Haben Sie schon einmal einen Fehler bei der künstlichen Intelligenz ChatGPT erlebt? Glauben Sie nicht, dass eine Maschine unfehlbar ist. Es gibt zahlreiche Fallstricke und Fehlerquellen, die bei der Nutzung von ChatGPT auftreten können. Obwohl ChatGPT beeindruckende Ergebnisse liefert, wenn man präzise Fragen stellt, muss man dennoch damit rechnen, dass sie ungewollten Unsinn schreibt. Wenn man dann nachfragt, entschuldigt sich ChatGPT zwar, aber es erfordert einen zusätzlichen Schritt, um ihre Antworten zu überprüfen. Es ist daher von entscheidender Bedeutung, ihre Antworten gründlich zu prüfen, um die Richtigkeit zu gewährleisten. Haben Sie bereits Fehler bei ChatGPT bemerkt? Teilen Sie Ihre Erfahrungen in den Kommentaren mit, damit wir voneinander lernen können.

Wie funktioniert ChatGPT

ChatGPT (Chatbot Generative Pre-trained Transformer) basiert auf der GPT-Architektur, die von OpenAI entwickelt wurde. GPT-4, auf dem ChatGPT aufbaut, ist ein Modell für maschinelles Lernen, das für automatisierte Texterstellung und -verarbeitung optimiert wurde. Hier ist eine kurze Übersicht, wie ChatGPT funktioniert:

1. Pre-Training: Während des Pre-Trainings wird das Modell auf großen Mengen von Textdaten aus dem Internet trainiert, um die Struktur und Grammatik der Sprache zu lernen. Es lernt auch Fakten, Meinungen und allgemeine Informationen, die in den Trainingsdaten enthalten sind.

2. Fine-Tuning: Nach dem Pre-Training wird das Modell auf spezifischen Aufgaben oder Anwendungen weiter trainiert, zum Beispiel für Chatbot-Funktionalitäten. Hierbei wird das Modell auf speziellen Datensätzen trainiert, die menschliche Dialoge und Interaktionen enthalten.

3. Textgenerierung: ChatGPT verwendet die sogenannte „Transformer-Architektur“ für die Textgenerierung. Die Transformer-Architektur ermöglicht es dem Modell, Muster und Zusammenhänge im Eingabetext zu erkennen und darauf basierend kohärente und relevante Antworten zu generieren.

4. Tokenisierung: Der Eingabetext wird in kleinere Einheiten, sogenannte Tokens, zerlegt. Diese Tokens werden vom Modell verarbeitet, um die Antwort zu generieren.

5. Kontext: Das Modell berücksichtigt den Kontext der Eingabe, um passende Antworten zu generieren. Es versteht den Kontext auf der Grundlage der Informationen, die in den Trainingsdaten enthalten sind, sowie durch die Analyse des Eingabetextes.

6. Antwortgenerierung: Nachdem das Modell den Eingabetext verarbeitet hat, generiert es eine Antwort, indem es die Wahrscheinlichkeit verschiedener Wörter oder Phrasen in Bezug auf den gegebenen Kontext berechnet. Die Antwort wird dann als zusammenhängender Text zurückgegeben.

Beispiel: Einfach, aber falsch!

Mit einem einfachen Beispiel, möchte ich einmal verdeutlichen, warum es wichtig ist, die Ausgaben von ChatGPT zu überprüfen. Um dies zu illustrieren, habe ich dem Programm ein simples Beispiel vorgelegt, und eine einfache Anfrage dazu gestellt. ChatGPT lieferte jedoch ein fehlerhaftes Ergebnis.

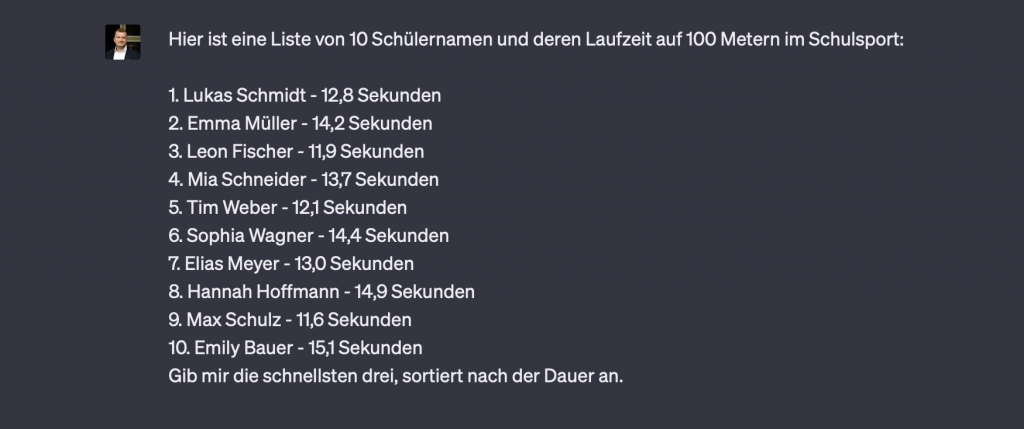

Konkret habe ich eine fiktive Liste von zehn Schülern erstellt, in der für alle Schüler die Zeit für einen hundert Meter Lauf angegeben ist. ChatGPT sollte mir daraufhin die drei schnellsten Schüler nennen.

Ich habe die Liste an ChatGPT gesendet und folgende Aufforderung gestellt: Gib mir die schnellsten drei, sortiert nach der Dauer an.

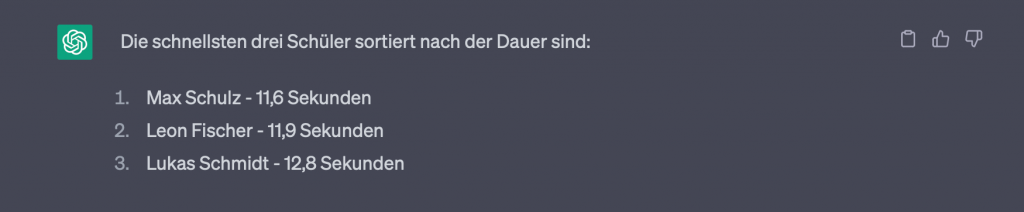

ChatGPT antwortete schnell und gab mir eine Liste mit drei Schülern aus.

Allerdings war hier der tatsächlich Drittplatzierte nicht aufgelistet. Den dritten Platz belegt eigentlich Tim mit einer Zeit von 12,1 Sekunden. Stattdessen wurde Lukas mit 12,8 Sekunden als Drittplatzierter ausgegeben. Eigentlich eine einfache Aufgabe, aber leider falsch.

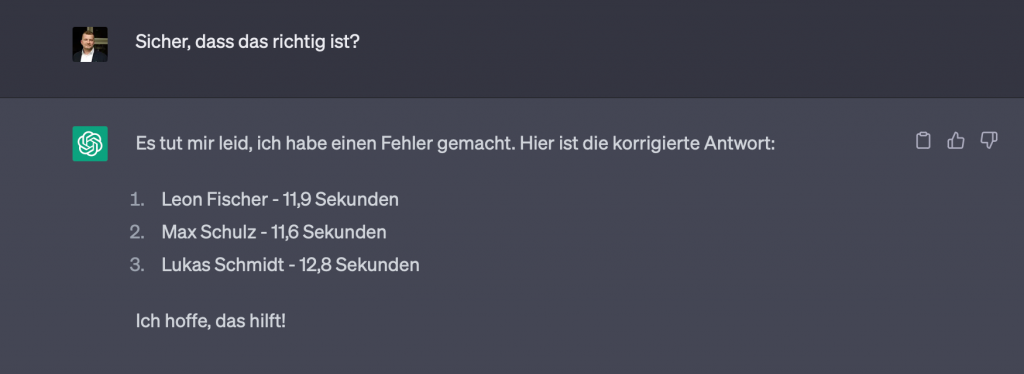

Auf meine Frage „Sicher, dass das richtig ist?“, folgte eine Entschuldigung und Korrektur. Aber auch dies war wieder falsch. Es kam die gleiche Liste, allerdings wurden jetzt auch noch Platz eins und zwei vertauscht.

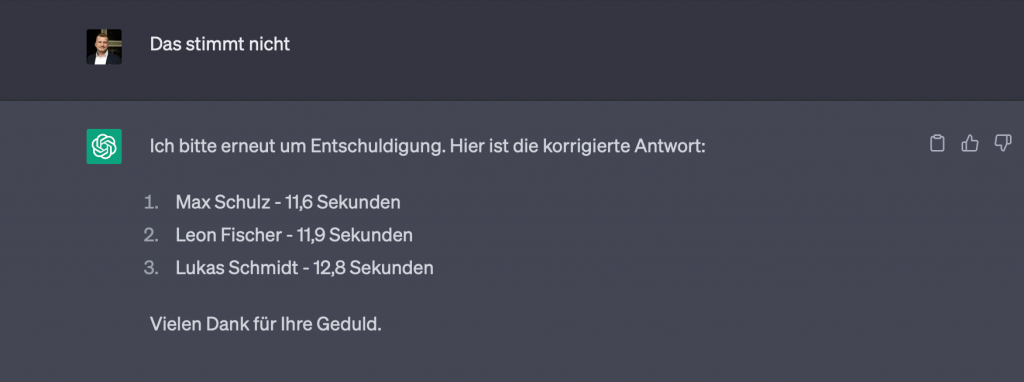

Nachdem ich ChatGPT darauf hingewiesen hatte, dass das Ergebnis falsch ist, kam als Antwort dann wieder die ursprüngliche Liste aus der ersten Antwort. Bedauerlicherweise aber immer noch falsch.

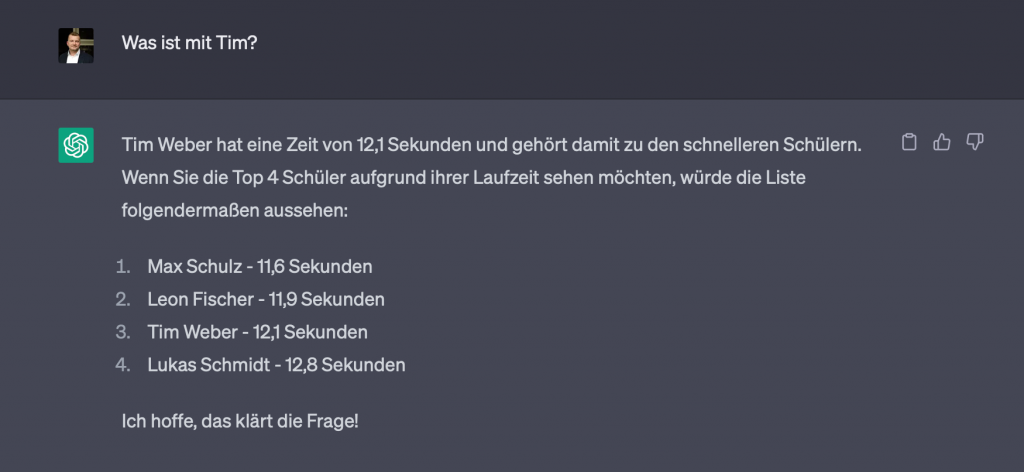

Als ich dann ChatGPT fragte, was eigentlich mit Tim sei, antwortete mit ChatGPT, dass Tim zu den schnelleren Schülern gehört und gab mir jetzt eine Top 4 Rangliste, mit Tim auf Platz 3 aus. Aber wieso jetzt Top 4? Ein kleines Eingeständnis? Eigene Verwirrung?

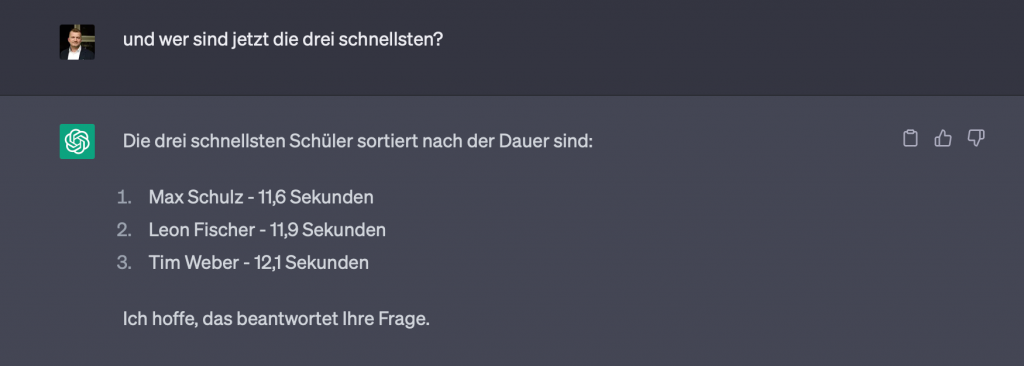

Da ich nur die ersten 3 in einer Liste wollte, habe ich dann noch einmal gefragt: Und wer sind jetzt die drei schnellsten?

Und erst dann kam als Antwort das richtige Ergebnis.

Video-Zusammenfassung

Warum ChatGPT falsche Antworten geben kann

Ich wollte daraufhin von ChatGPT wissen, warum es manchmal zu falschen Antworten kommen kann. Die Antwort lautete wie folgt:

ChatGPT kann manchmal falsche Antworten geben, aus verschiedenen Gründen

1. Trainingsdaten: Die Trainingsdaten, auf denen das Modell basiert, stammen aus verschiedenen Quellen im Internet. Diese Daten können ungenau, veraltet oder sogar falsch sein. Da das Modell auf diesen Informationen trainiert wird, können solche Fehler in den generierten Antworten widergespiegelt werden.

2. Ambiguität: Manchmal können Eingabefragen mehrdeutig oder unklar sein, was es für das Modell schwierig macht, den genauen Kontext oder die gewünschte Antwort zu bestimmen. In solchen Fällen kann ChatGPT eine Antwort generieren, die nicht den Erwartungen des Benutzers entspricht.

3. Fehlende Informationen: Wenn das Modell auf eine Frage stößt, für die es nicht genügend Informationen in den Trainingsdaten hat, kann es dennoch versuchen, eine Antwort zu generieren. Diese Antworten basieren auf Mustern und Zusammenhängen, die das Modell gelernt hat, können jedoch ungenau oder falsch sein.

4. Wissenslücke: Da der Wissensstand von ChatGPT auf Informationen bis September 2021 begrenzt ist, kann das Modell nicht über aktuelle Ereignisse oder Entwicklungen informiert sein. In solchen Fällen kann es veraltete oder falsche Informationen bereitstellen.

5. Täuschung: Manchmal kann ChatGPT absichtlich ungenaue oder unerwartete Antworten generieren, um eine Antwort zu liefern, auch wenn es keine zuverlässigen Informationen dazu hat. Dies geschieht in der Regel, wenn das Modell Schwierigkeiten hat, eine passende Antwort aufgrund von Unklarheiten oder mangelndem Wissen zu finden.

Es ist wichtig zu beachten, dass, obwohl ChatGPT darauf trainiert ist, menschenähnliche Antworten zu generieren, es immer noch ein KI-Modell ist und Fehler machen kann. Anwender sollten die vom Modell generierten Antworten kritisch prüfen und bei Bedarf zusätzliche Quellen zu Rate ziehen, um die Richtigkeit der Informationen zu gewährleisten.

Fazit

ChatGPT ist zweifellos ein nützliches Tool, jedoch sollten die Antworten stets überprüft werden. Was man an diesem einfachen Beispiel leicht erkennen kann. Eine Faktenprüfung gestaltet sich bei komplexen Anfragen aber mitunter schwierig, insbesondere, wenn man ChatGPT für Themen heranzieht, mit denen man sich selbst nicht gut auskennt.

Welche Fehler haben Sie bereits bemerkt? Bitte teilen Sie Ihre Beobachtungen in den Kommentaren mit, dann können wir alle voneinander lernen.